Парсеры и скрапперы

Создаю мощные парсеры для сбора и обработки данных любой сложности

Заказать парсерРазработка парсеров и скрапперов

Создаю высокопроизводительные парсеры для сбора данных с веб-сайтов, обработки файлов и автоматизации процессов. Опыт обработки миллионов файлов.

Что вы получаете:

- Высокая производительность: Обработка миллионов файлов

- Многопоточность: Параллельная обработка данных

- Обход защиты: Работа с капчей и блокировками

- Структурированные данные: Автоматическая очистка и форматирование

- Мониторинг: Отслеживание изменений и уведомления

- API интеграция: Подключение к внешним сервисам

Типы парсеров:

Веб-скрапинг

Сбор данных с веб-сайтов, новостей, товаров

Обработка файлов

Парсинг документов, изображений, архивов

Анализ данных

Статистика, тренды, отчеты

Мониторинг

Отслеживание изменений в реальном времени

Процесс разработки:

Анализ источника

Изучаю структуру данных, определяю методы парсинга

Проектирование

Создаю архитектуру парсера, планирую обработку данных

Разработка

Пишу код, настраиваю производительность, тестирую

Оптимизация

Улучшаю скорость, добавляю обработку ошибок

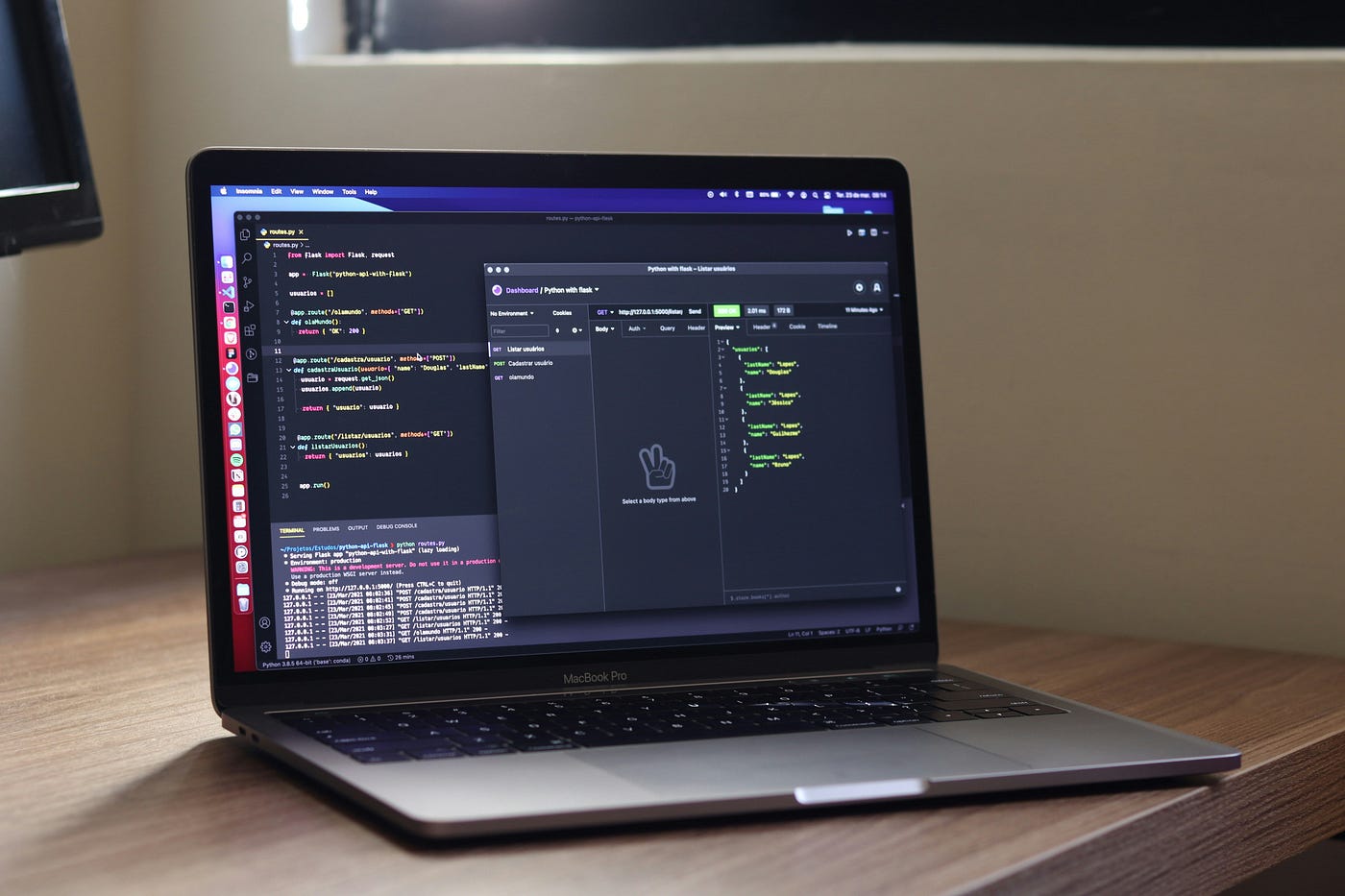

Используемые технологии:

Готовы заказать парсер?

Оставьте заявку, и я свяжусь с вами для обсуждения вашего проекта. Предоставлю бесплатную консультацию и оценку стоимости разработки.